728x90

다양한 LLM opensource 모델들을 손쉽게 사용할 수 있는

Ollama 가 오픈되어 공부중인데요~!@

Ollama

Get up and running with large language models, locally.

ollama.ai

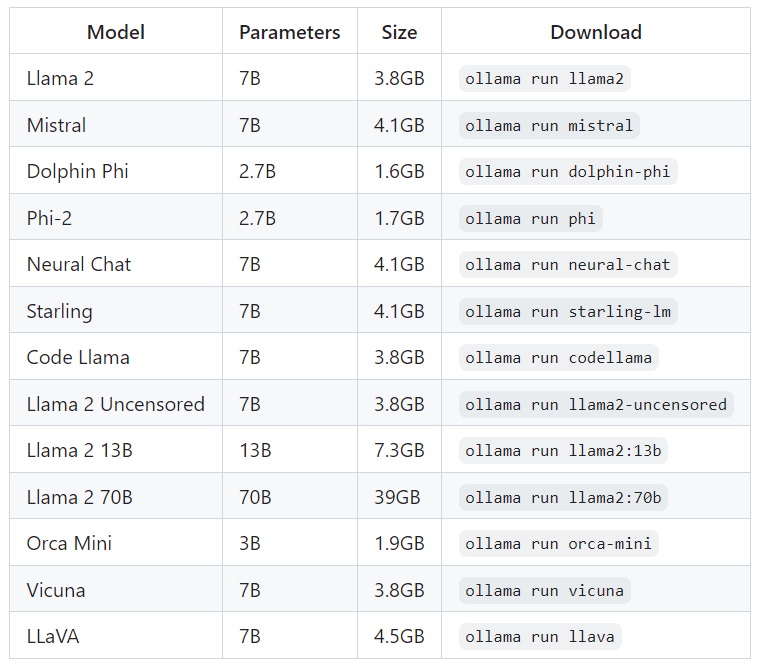

3.8GB의 LLAMA 7B 모델부터 39GB가 넘는 LLAMA2 70B 모델까지

여러 공개된 오픈소스 모델들의 사용이 가능합니다!

https://ollama.ai/library/llama2-uncensored/tags

Tags · llama2-uncensored

Uncensored Llama 2 model by George Sung and Jarrad Hope.

ollama.ai

70B등 대규모 모델을 사용하다보면, 현 디렉토리 용량이 부족해서 다운로드가 안될때가 있는데,

이때의 해결방법을 알아냈습니다!.

>> 기존 ollama 실행법

- 이 때에는 ollama의 파일들이 default directory인 :~/.ollama/models/blobs 에 저장됩니다.

## ollama 다운

curl https://ollama.ai/install.sh | sh

## 57GB 짜리 모델 다운로드 및 실행

ollama run llama2-uncensored:70b-chat-q6_K

>> 내가 필요한 디렉토리에 ollama 실행방법

## 기존 실행중인 ollama 현황 확인

systemctl status ollama

##기존 실행중인 ollama 종료

systemctl stop ollama

## ollama를 새로운 목표하는 디렉토리에서 실행

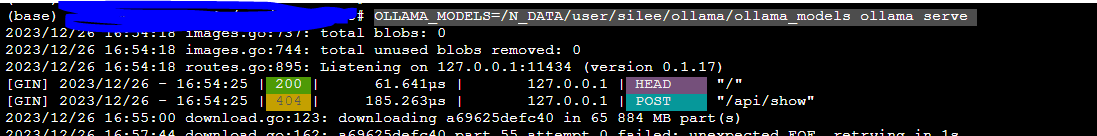

OLLAMA_MODELS={목표디렉토리} ollama serve

## (예시)$ OLLAMA_MODELS=/N_DATA/user/silee/ollama/ollama_models ollama serve- 위 방식으로 진행하게되면 {목표디렉토리} 내에 blobs라는 폴더가 생기도 해당 폴더에 저장됩니다!

아래와 같이 서비스가 실행되며 목표하는 디렉토리에 파일이 저장됩니다!

ㅁ 참고

https://github.com/jmorganca/ollama/pull/897

감사합니다.

728x90

'데이터&AI > LLM' 카테고리의 다른 글

| chatgpt 스토어를 알아보쟈!! (1) | 2024.01.15 |

|---|---|

| llamafile 포트 및 ip 정보 바꾸기!! (0) | 2023.12.27 |

| LLM 모델 팔콘 알아보기 (Falcon-180b) (1) | 2023.12.02 |

| 초거대언어모델(LLM) 의 성능평가지표 (feat. MMLU, Helloswag) (1) | 2023.12.01 |

| GPT를 On-premise에서 사용하고 싶을때는?? (0) | 2023.04.12 |

댓글