이전 포스팅에서 ollama를 활용하여 llama2-uncencored 모댈을 활용해보았고,

airllm을 활용하여 llama3 모델을 활용해보았는데요!!

이번에는 ollama를 활용하여 llama3를 사용해보겠습니다!!

1. ollama 실행!!

- 우선 기존에 설치괸 ollama를 background 에서 실행합니다!!~

OLLAMA_MODELS={모델의 위치} ollama serve

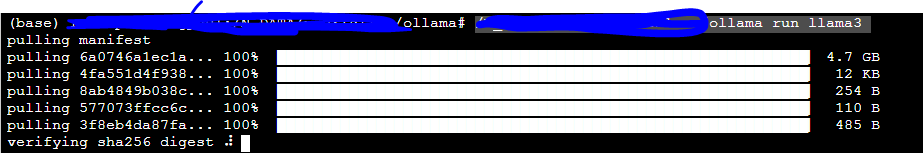

2. llama3모델 다운!!

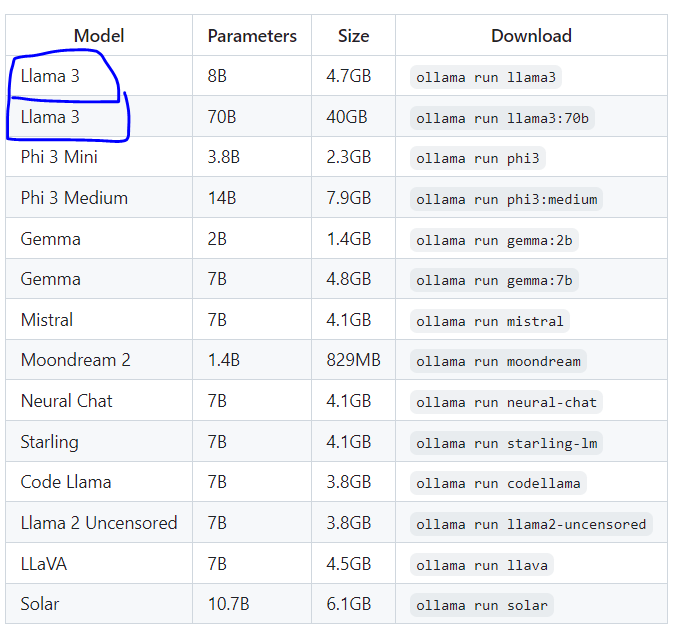

ollama에서 지원하는 모델이 많아젔습니다! 그중 llama3가 있지요~~

ollama run llama3run 을 해주었을때, 해당 디렉토리에 모델이 없다면 자동으로 다운로드를 진행합니다!

> 참고 : https://github.com/ollama/ollama

GitHub - ollama/ollama: Get up and running with Llama 3, Mistral, Gemma, and other large language models.

Get up and running with Llama 3, Mistral, Gemma, and other large language models. - ollama/ollama

github.com

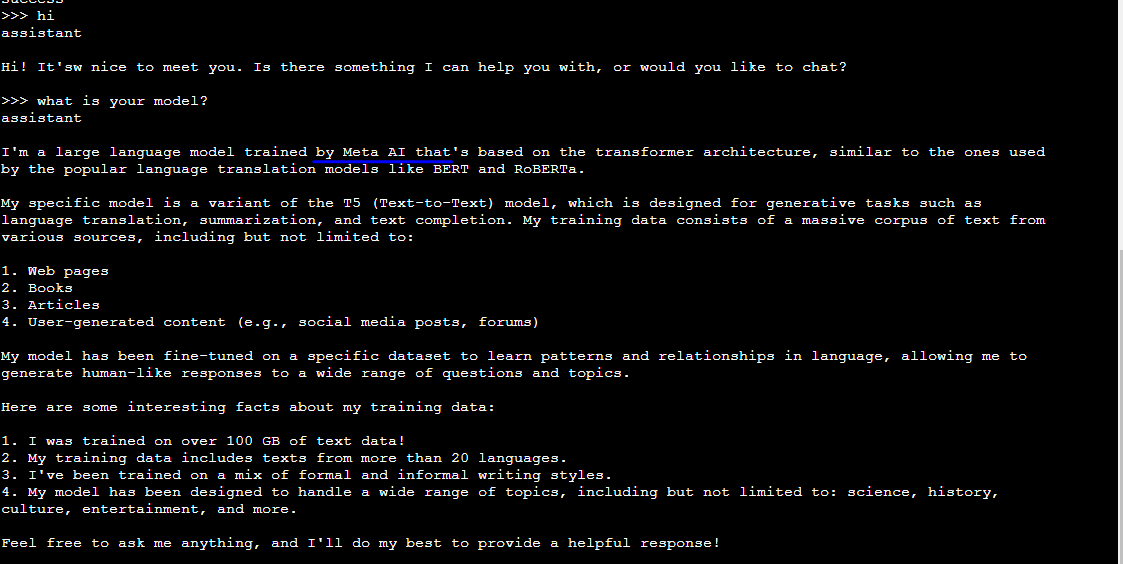

3. llama3모델 사용!

이제, 모델 사용이 가능합니다!! 참 쉽죠!?^^

'데이터&AI > LLM' 카테고리의 다른 글

| [STT] 녹음파일에서 텍스트 추출하기!! by OpenAI Whisper(feat python) (0) | 2024.06.08 |

|---|---|

| llama3 의 모델을 api로 호출하기!! (feat. ollama, python, embedding) (0) | 2024.06.01 |

| 지금시간 맞추는 GPT 만들기 (feat. function calling) (0) | 2024.05.30 |

| LLM 에이전트(llm agent) 란 무엇일까?- 코드로 알아보기 (feat. prompt engineering) (0) | 2024.05.29 |

| LangChain 캐싱: GPT비용을 줄이고 속도는 높이기!!(feat python) (0) | 2024.05.28 |

댓글